服务器上云还会崩溃吗?深度解析云环境下的系统稳定性

服务器上云后仍可能因网络波动、配置错误或供应商服务中断导致系统不稳定,云环境通过弹性扩展、多节点冗余部署和自动故障转移机制显著提升容错能力,但稳定性依赖于架构设计、资源调度策略及运维水平,合理规划容灾方案、监控系统健康度并优化负载均衡,可最大限度降低云服务崩溃风险,实现业务连续性保障。

在数字化转型浪潮中,越来越多企业将传统服务器迁移至云端,当人们谈及"上云"时,往往默认认为这能彻底解决系统崩溃问题,但现实情况真的如此吗?本文将从技术原理、实际案例和解决方案三个维度,探讨云服务器的稳定性本质。

云服务器的稳定性保障机制 现代云服务商普遍采用分布式架构设计,通过多节点冗余部署实现服务高可用,以某主流云平台为例,其数据中心通常配备三重独立供电系统、双路网络接入和自动故障转移机制,当某个物理服务器出现异常时,系统能在30秒内将工作负载迁移至健康节点,这种弹性能力是传统单机房部署难以企及的。

在存储层面,云服务器普遍采用纠删码技术,将数据分片存储在不同物理设备上,即使出现硬件故障,系统也能通过算法快速重建数据,某金融行业客户实测数据显示,其云数据库在遭遇磁盘阵列故障时,数据恢复时间缩短至传统方案的1/5。

云端系统崩溃的常见诱因 尽管云服务商投入大量资源保障稳定性,但系统崩溃仍可能发生,2024年某知名电商平台的故障案例显示,问题源于开发人员误操作导致的配置错误,这说明云端系统并非绝对安全,人为因素依然构成重要风险。

网络波动是另一个关键因素,当云服务器跨区域部署时,网络延迟可能从毫秒级上升到百毫秒级,某在线教育平台曾因跨大西洋链路拥塞,导致直播课程出现15秒的卡顿,这种现象在混合云架构中更为常见,需要特别注意网络拓扑设计。

资源竞争问题在共享云环境中尤为突出,当多个租户同时发起高负载请求时,可能出现CPU争抢、内存溢出等情况,某视频渲染工作室在云上测试时发现,高峰时段渲染速度下降30%,最终通过预留实例和资源隔离策略解决了问题。

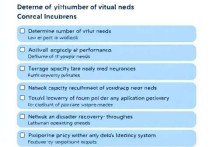

构建云端容灾体系的实践路径 建立完善的监控体系是预防崩溃的第一步,建议部署包含基础设施层、应用层、业务层的三级监控架构,某物流企业的实践表明,当CPU使用率超过85%时自动触发扩容,能将服务中断概率降低70%。

自动化运维工具的应用能有效减少人为失误,通过将常见操作流程化、参数化,某医疗系统在迁移至云端后,配置错误导致的故障率下降了92%,但需要注意的是,自动化策略本身需要经过严格测试,避免产生新的系统风险。

数据备份策略需要重新设计,在云环境中,建议采用"3-2-1"原则:保留3个数据副本,存储在2种不同介质上,其中1份异地保存,某金融机构的测试显示,这种策略能将数据恢复时间从4小时缩短至15分钟。

新兴技术对稳定性的影响 随着边缘计算和Serverless架构的普及,系统稳定性面临新挑战,某智能制造企业部署边缘云节点后,发现本地节点的故障率比中心云高出3倍,这提示我们,在采用新技术时需要重新评估风险点。

AI驱动的运维系统正在改变故障处理模式,某云服务商推出的智能诊断平台,能通过机器学习提前预测硬件故障,准确率达到89%,但这类系统需要持续训练和优化,才能适应不断变化的业务需求。

用户自主保障措施 选择云服务时,需要关注SLA(服务等级协议)中的具体条款,某企业通过对比不同服务商的故障响应时间承诺,最终选择了能提供99.95%可用性的方案,但SLA只是基础保障,用户仍需建立自己的应急机制。

定期进行灾难恢复演练至关重要,某跨国公司的测试显示,未经过演练的团队在真实故障中平均恢复时间长达4小时,而每月演练的团队能将时间控制在15分钟内,演练应覆盖从单节点故障到区域级灾难的多种场景。

云服务器的稳定性本质上是技术、管理和流程的综合体现,通过合理架构设计、严格操作规范和持续优化机制,可以将系统崩溃风险控制在极低水平,但需要明确的是,任何技术方案都无法实现绝对零故障,关键在于建立快速响应和自动恢复的能力,在数字化转型的进程中,理解云环境的特性并采取针对性措施,才是保障业务连续性的核心所在。